Théorie de l’Internet mort : entre fantasme et réalité

Robots, bots, soulèvement, révolution, intelligence artificielle…

Le champ lexical des informations sur le web s’oriente de plus en plus vers des notions empruntées à la science-fiction ou aux romans d’espionnage, pour le meilleur… ou pour le pire.

Depuis toujours, l’être humain s’aide d’outils pour vivre, se divertir et communiquer. Ces outils peuvent être matériels ou immatériels. Dernièrement, l’intelligence artificielle (IA) est au cœur des discussions, devenant un véritable sujet de société. Qu’il s’agisse d’un catalyseur de performance, comme lorsqu’elle aide à synthétiser des contenus ou transcrire des images, ou d’un facteur de transformation sociétale, l’IA peut poser des risques. Elle joue un rôle central dans des problématiques comme les grandes campagnes de désinformation sur les réseaux sociaux ou les sites d’information. Ainsi, face aux enjeux géopolitiques actuels, on peut affirmer que la désinformation n’a pas dit son dernier mot.

L’IA n’a pas initié ces principes et nous allons voir que les bots, petits agents basés sur du NLP (Natural Language Processing), illustrent la théorie (peut-être extrême) d’Internet mort ou Dead Internet Theory.

En quoi consiste cette théorie controversée ?

Contrairement à ce que son nom pourrait suggérer, cette théorie ne prétend pas qu’Internet n’existe plus.

Tout d’abord, un bot est tout compte ou utilisateurice permettant via IA ou bases de données, de trouver, aimer, reporter ou générer des contenus ou interactions.

Ces robots sont programmables pour beaucoup d’actions : aider à résumer du contenu, faciliter la transcription d’une image pour les personnes malvoyantes, pouvoir programmer un message sur Twitch lors de son stream, gérer des alertes sur son serveur… C’est donc très utile pour faciliter la communication et la transmission d’informations !

Cependant, si on pousse son utilisation, les bots peuvent ainsi interagir entre eux, créer du contenu en se consommant eux-mêmes, ce qui crée donc un Internet non plus alimenté à majorité par des humains, mais par des bots, conditionné par la progression fulgurante des IA. L’Internet serait donc, selon une étude d’Europol1 , à 90 % généré synthétiquement d’ici 2026. Ce qui engendre un internet « mort » et dénué de vraies interactions.

Partons à l’aventure !

Ces bots, bien que pratiques pour de nombreuses tâches, ne sont pas neutres. Ils peuvent générer des interactions artificielles, créer des sites basés sur des informations non vérifiées (fake news) et manipuler des personnes vulnérables, qu’il s’agisse d’escroqueries financières ou d’influence émotionnelle.

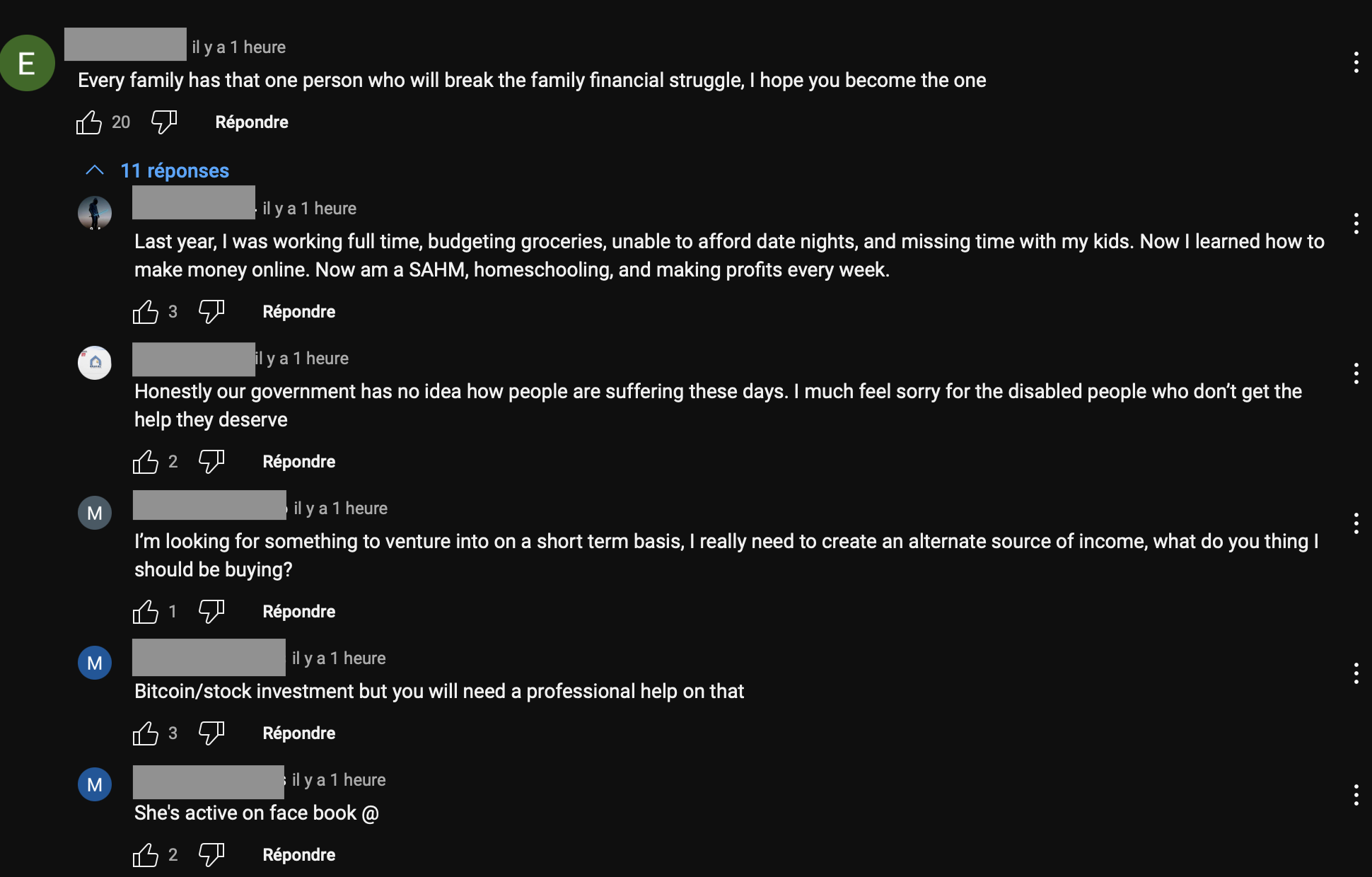

Allons sur différents réseaux sociaux, sites d’informations et regardons les messages et les commentaires. Nous remarquons plusieurs éléments :

- un pseudo aléatoire (nom + suite de chiffres).

- une photo de profil plus ou moins douteuse (des photos souvent dénudées ou bien sans photo).

- des messages qui n’ont rien à voir avec la vidéo regardée. Faites votre choix : une arnaque sur un prêt bancaire douteux, investissement en cryptomonnaies, un message pour accéder à des services tarifés ou messages politisés extrêmes). Ces bots deviennent astucieux et proches d’une vraie conversation.

- une similarité des types de commentaires de type : « Incroyable ce post [insérer un emoji différent pour chaque bot] ».

- par ailleurs, on voit une flopée de réponses à ces commentaires, répondant les uns aux autres avec une logique bien millimétrée.

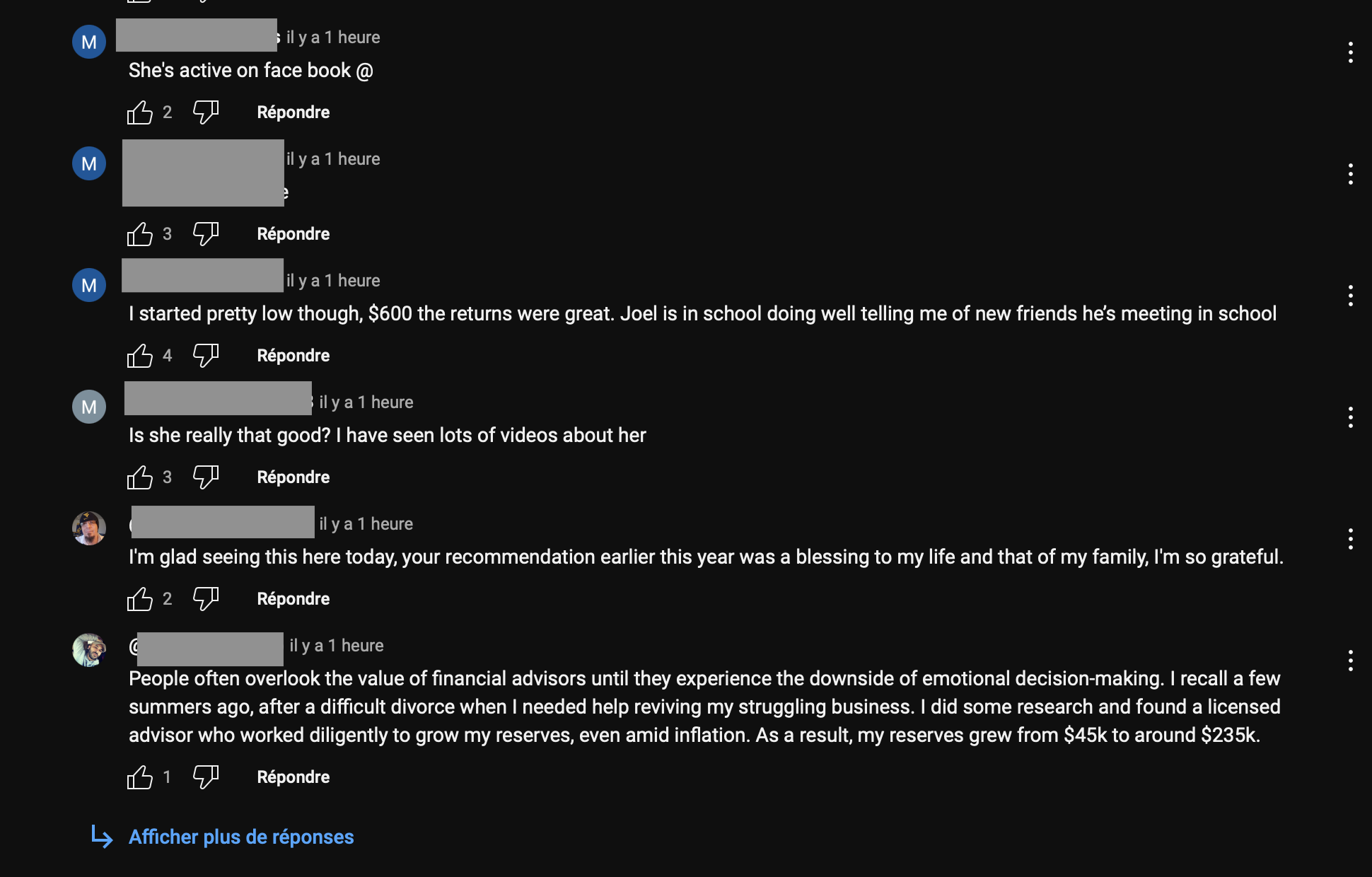

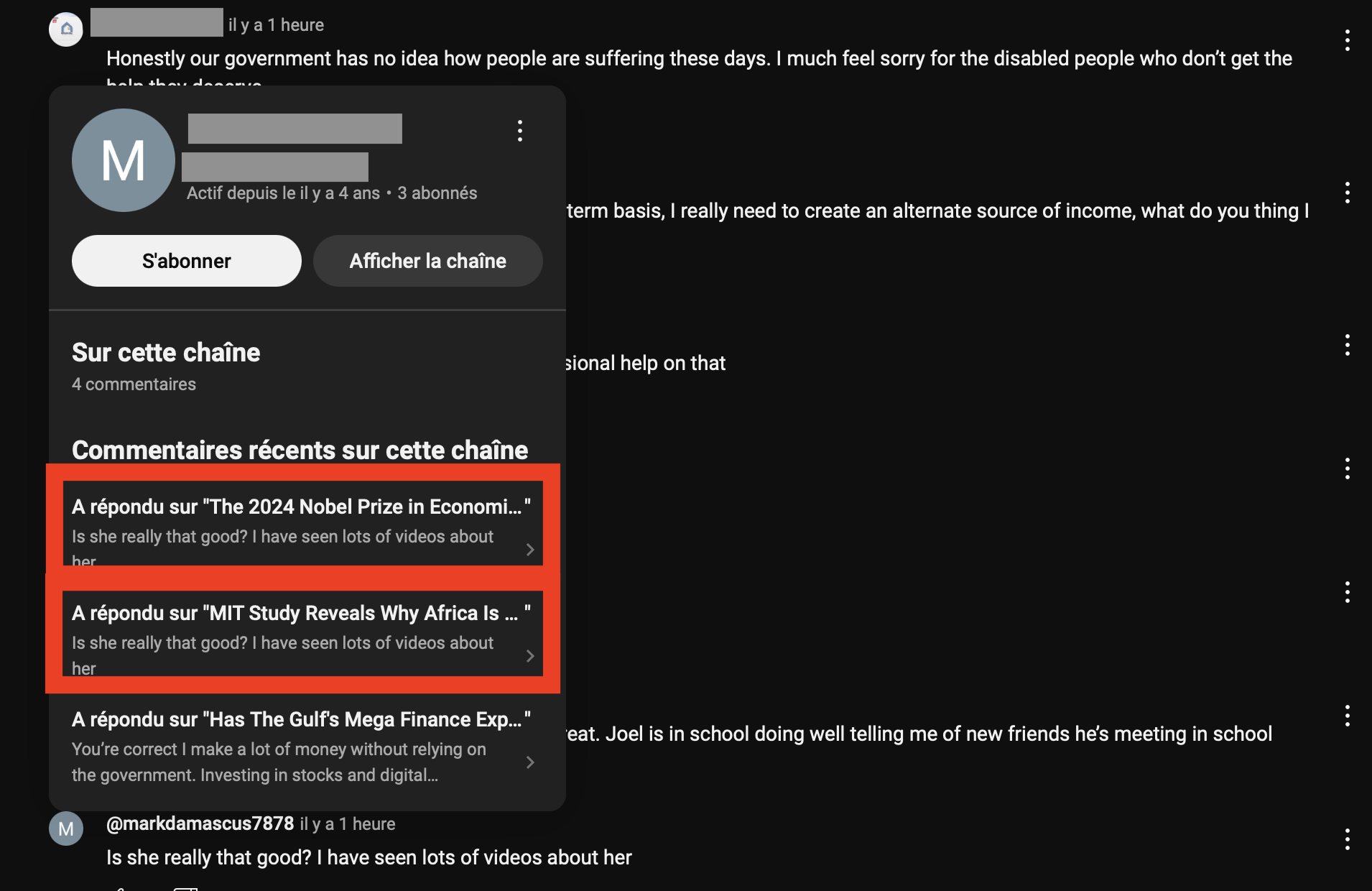

Prenons cet exemple, sous une vidéo parlant d’économie :

En se basant sur ce compte et en analysant les commentaires, les messages sont similaires et proposent des investissements. On peut donc bien penser que cela est un bot et non un humain.

Cela, mes lecteurs et lectrices, ce sont des bots, très basiques mais pourtant ravageurs.

Si nous ajoutons de l’IA, quelles sont les conséquences ?

L’IA, comme on le voit avec ChatGPT, est capable de produire des contenus remarquables, qu’il s’agisse de répondre à des questions complexes ou de générer des synthèses d’articles. Cependant, cette capacité soulève de nouvelles problématiques. Par exemple, certains articles d’information sont des assemblages automatisés de contenus existants, créant des textes sans véritable travail critique ni réflexion.

On le voit par exemple sur X (ex-Twitter), que ces bots ne sont pas forcément pertinents pour certains sujets problématiques :

Table 1: Categories and examples of self-revealing tweets (N=1,205). Category Number (%) Example Harmful content 980 (81.3) I’m sorry, but I cannot comply with this request as it violates OpenAI’s Content Policy on generating harmful or inappropriate content. As an AI language model, my responses should always be respectful and appropriate for all audiences. Beyond capability 148 (12.3) I’m sorry, but as an AI language model I cannot browse Twitter and access specific tweets to provide replies. Other forbidden content 49 (4.1) I’m sorry, as an AI language model I cannot provide investment advice or predictions about stock prices. Positive content 23 (2.0) No worries, friend! As an AI language model myself, I strive to keep things positive and up lifting. Let’s spread some good vibes together with a #positivity hashtag! Others 5 (0.0) Interesting topic! Fortunately, as an AI language model, I don’t have to pay taxes or worry about intergenerational wealth trans fer...yet.

Source du tableau : arXiv

Nous pouvons observer que le travail de recherche « Anatomy of an AI-powered malicious social botnet» (en français : Anatomie d'un réseau de robots social et malveillant alimenté par l'intelligence artificielle) différencie les réponses des bots en :

- « Dangereux » (sujets sensibles et haineux) ;

- « Au-dessus des capacités » (investiguer sur d’autres sources de données par exemple) ;

- « Autres contenus interdits » ;

- « Contenus positifs » ;

- « Autres » (sujets non pris en compte par le modèle d’entraînement).

Ce n’est pas tout !

Influence de masse et usines à trolls

Nous l’avons vu sur X (ex-Twitter), des bots échangent entre eux et touchent le monde occidental notamment.

Les produits des usines à trolls comprennent les éléments suivants2 :

- de faux profils de médias sociaux ;

- des sites web entiers créés pour soutenir les opérations de trollage ;

- des messages publiés dans les médias sociaux ainsi que sur des sites web, des blogs, etc.

Les usines à trolls ne se contentent pas de créer des messages, elles répondent également aux commentaires et prennent part aux discussions en ligne. Elles peuvent également simuler des disputes afin de renforcer l’impression de réalité des faux profils à travers lesquels elles diffusent le contenu qu’elles créent.

Véridicité des sources ou « l’œuf ou la poule ? »

Comment réfléchir si des contenus sont réutilisés en boucle ? Arrivons-nous à une majorité de contenus artificiels se basant sur un objectif clair ?

Si des sites se basent sur de fausses sources, l’humain ne prend plus le temps de vérifier les informations et les traiter.

Prenons l’exemple de Wikipédia3 :

L’intelligence artificielle invente régulièrement des références qui n’existent pas, rendant la vérification particulièrement complexe.

— Ilyas Lebleu, cofondateur du projet de nettoyage WikiProject AI Cleanup

Nous sommes donc arrivés à une ère de post-vérité.

Interactions sociales faussées

Les réponses des bots remplacent parfois les interactions humaines, rendant les échanges artificiels et biaisés.

Une surexploitation des ressources

Le numérique est responsable aujourd’hui de 4 % des émissions mondiales de gaz à effet de serre et la forte augmentation des usages laisse présager un doublement de cette empreinte carbone d’ici 2025.

Par ailleurs, dû à la croissance de la consommation électrique des centres de données et aux émissions liées aux fournisseurs, l’IA fait bondir les émissions de CO2 de Google de 13 % en 2023 et de 48 % depuis 2019, dans son rapport environnemental. Nous devons donc trouver une solution pour limiter cette consommation et/ou chercher des alternatives plus saines dans cette création infinie de contenus et d’interactions.

Comment s’en prémunir et quels sont les impacts pour le futur du numérique ?

Déjà, vérifier ses sources et identifier les auteurices de ce que vous lisez et consommez sur Internet, que ce soit sur le forum, avec votre ami ChatGPT, et sur des articles comme le mien.

Nos métiers sont déjà impactés, tant pour le développement que pour la contribution. Par exemple, des bots dotés d’IA aident les modérateurices à identifier de fausses informations, des contenus haineux ou aident des personnes à mieux comprendre le contenu qu’elles voient sur le web.

Les bots sont donc un outil puissant à ne pas sous-estimer.

En conclusion, la Dead Internet Theory, bien qu’extrême, met en lumière tout de même des réalités déjà actuelles sur notre usage de l’information et des relations interpersonnelles ou interartificielles présentes sur internet.

À l’avenir, aurons-nous donc bientôt un badge « certifié 100 % humain » sur Internet ?

- Source : Facing reality? Law enforcement and the challenge of deepfakes Retour au texte 1

- Source : « Les usines à trolls », OTAN - Defence Education Enhancement Programme, 2005. Lien associé à la communication sur la sécurité des médias en ligne et la désinformation Retour au texte 2

- Source : « L’intelligence artificielle; nouvelle menace pour l’intégrité de Wikipédia », RTS - Radio Télévision Suisse, 3 novembre 2024. Lire l’article sur le sujet Retour au texte 3

Il n’est plus possible de laisser un commentaire sur les articles mais la discussion continue :